618

2023年10月11日,北京金秋时节,第九届HAOMO AI DAY如期而至。本届HAOMO AI DAY以 "BETTER AI,BETTER HAOMO"为主题。毫末重磅发布三款“极致性价比”千元级无图NOH,全面满足高中低价位智驾车型量产需求;毫末发布的行业首个自动驾驶生成式大模型DriveGPT雪湖·海若公布最新成果:共计筛选出超过100亿帧互联网图片数据集和480万段包含人驾行为的自动驾驶4D Clips数据;进一步升级引入多模态大模型,获得识别万物的能力;与NeRF技术进一步整合,渲染重建4D空间;借助LLM(大语言模型),让自动驾驶认知决策具备了世界知识。产品层面,搭载毫末城市NOH功能的魏牌蓝山将在2024年第一季度正式量产上市;小魔驼即将在2023年第四季度在商超履约配送场景实现盈利。

毫末CEO顾维灏认为,自动驾驶3.0时代与2.0时代相比,其开发模式和技术框架都将发生颠覆性的变革。在自动驾驶2.0时代,以小数据、小模型为特征,以Case任务驱动为开发模式。而自动驾驶3.0时代,以大数据、大模型为特征,以数据驱动为开发模式。

P1

大家好,欢迎大家来到第九届HAOMO AI DAY。特别感谢郭明明副书记、张亚勤院士、李升波教授等众多嘉宾的到来。HAOMO AI DAY因为各位专家、学者、产业嘉宾、媒体朋友的参与,已经成为了中国自动驾驶行业备受瞩目的自动驾驶AI技术交流的平台,甚至被评价为中国自动驾驶技术的旗帜,我们一定会努力继续把它做好,非常感谢大家对HAOMO AI DAY的喜爱和支持。

每次HAOMO AI DAY,我们都希望将毫末在自动驾驶技术上最前沿技术探索和当前实践进展分享给行业。上次的AI DAY我们发布了行业首个自动驾驶生成式大模型DriveGPT,目标是探索一种实现端到端自动驾驶的新范式,在自动驾驶3.0时代,大模型将重塑汽车智能化的技术路线,今天,我就继续分享毫末在这方面上的思考和实践。

P2

毫末一直以数据驱动的方式来推动自动驾驶产品的升级。

截止到2023月10月,毫末数据智能体系MANA的学习时长超过103万小时。乘用车用户辅助驾驶行驶里程已经接近9000万公里,正在向1亿公里迈进,搭载毫末高阶智驾的车型已经落地欧盟。

随着毫末产品落地规模的不断增长,毫末智驾数据迎来爆发式增长,将预计在2023年正式迈入自动驾驶3.0时代所标定的1亿公里的智驾里程规模。毫末的数据闭环能力与产品迭代能力形成正向加速闭环。

P3

在产品迭代能力上,毫末辅助驾驶产品HPilot两代产品实现多次OTA升级,在高速NOH功能场景上有着越来越出色的表现。

根据我们的统计,使用毫末HPilot智能辅助驾驶产品的用户月度活跃率达到88%,

在媒体的600多公里的评测中,主动变道成功率达95.6%。

在搭载HPilot产品的车辆中,一位摩卡用户单辆最长累计智驾里程是82073公里,智驾功能使用率76.2%;这位摩卡用户相当于使用辅助驾驶绕着地球跑了快两圈了。

P4

更多用户在车主论坛,魏牌App等社交平台在分享使用毫末HPilot功能的反馈。

很多用户都觉得我们的智慧巡航功能非常好用,变道顺滑、过弯丝滑,对于加塞的处理也能快速应对,安全感满满的同时可以体会到智驾的乐趣。

很多开启高速NOH的用户,也对压速变道、智慧躲闪等功能给出了充分的认可,自动上下匝道也减轻了用户在切换高速时的认路压力;即使在拥堵路段,跟着缓行也能轻松应对。

毫末HPilot产品活跃度的爆发,是因为智驾功能实实在在地带给用户非常好的驾车体验,极大缓解了长途驾驶的疲劳感,安全、轻松、省心、丝滑,这些是我们从大量用户反馈中最常见到的评价。这说明毫末HPilot产品已经从用户尝鲜的时髦功能变成他们日常出行习以为常的实用功能。

用户大量真实的使用体验反馈,正是我们坚定投入自动驾驶技术的最好强心剂。

P5

相信大家已经多次见过我们在2022年发布的自动驾驶3.0时代的演进图。现在,我们更加笃定毫末对于自动驾驶技术发展阶段的判断。

当前,以数据驱动实现自动驾驶的技术路线成为行业共识,从海量大规模自动驾驶行驶里程中提取高质量数据,来完成大模型训练和自动驾驶算法的优化也成为主流方法,以AI大算力为特点的自动驾驶智算中心成为不少主机厂和自动驾驶公司重点投入的方向。

大模型、大数据、大算力,成为自动驾驶公司迈入3.0时代的关键标志。很庆幸,毫末从一开始就在为自动驾驶3.0时代作准备。在感知、认知、智算中心的建设上,毫末都是按照数据驱动的方式建设的。

目前在数据积累上即将实现一亿公里智能驾驶行驶里程的目标,同时MANA OASIS已经具备处理更大规模数据的能力,毫末DriveGPT大模型也在加速进化中,毫末为进入自动驾驶的3.0时代做好了充分准备。

P6

在自动驾驶3.0时代,开发模式将发生颠覆性的变革,我们可以对2.0与3.0时代的开发模式做一个简单的对比:

在小数据小模型2.0时代,我们通过多个小模型来解决自动驾驶问题,并通过case驱动的开发模式来解决问题。我们通常需要先发现一个问题,再基于这个问题的特征去采集一批数据,然后对这批数据进行人工标注,再基于人工标注的数据训练一个小模型,这个小模型就具备解决这个特定问题的能力了。这种模式有两个问题:一方面,只有问题暴露并确认之后,我们才能着手去解决问题,滞后性严重;另一方面,这种面向特定问题的小模型,泛化性非常差,无法面对开放世界的无穷问题。

而在大数据、大模型的3.0时代,数据驱动的大模型。在感知阶段,通过海量的数据训练感知基础模型,学习并认识客观世界的各种物体;在认知阶段,则通过海量司机的驾驶行为数据,来学习驾驶常识,通过数据驱动的方式不断迭代并提升整个系统的能力水平。

通过上述对比,我们确信在大数据大模型的开发模式下,未来的自动驾驶技术框架也会发生颠覆性的变化。在2.0时代,我们通过视觉、Lidar、Radar等多传感器融合方式完成对世界的感知,再通过预测、规划、决策、控制来完成认知决策和车辆控制。

在3.0时代,我们首先会在云端实现感知大模型、认知大模型的能力突破,并将车端各类小模型逐步统一为感知模型和认知模型,同时将控制模块也模型化。可以说,车端未来的演进路线一方面是会逐步全链路模型化、另一方面是逐步大模型化,即小模型逐渐统一到大模型内。大模型也可以通过剪枝、蒸馏等方式逐步提升车端的感知能力,在通讯环境比较好的地方,大模型甚至可以通过车云协同的方式实现远程控车。最终,我们相信,在未来车端、云端都是端到端的大模型。

P7

在过去的200多天里,DriveGPT在MANA OASIS雪湖·绿洲智算中心日夜不停地进化,到今天为止,我们已经训练了超过100亿帧互联网图片数据集,480万包含人驾行为的自动驾驶4D Clips,以及8700万公里的训练里程。如此巨大的数据规模是人类穷尽一生都难以完成的。

除了不断扩大数据规模,DriveGPT过去200天也在不断增强能力,通过引入多模态大模型,实现文、图、视频多模态信息的整合,获得识别万物的能力;通过与NeRF技术整合,实现4D空间的重建,获得对三维空间和时序的全面建模能力;再借助大语言模型LLM,将世界知识引入自动驾驶策略中。未来的自动驾驶系统一定是跟人类驾驶员一样,不但具备对三维空间的精确感知测量能力,而且能够像人类一样理解万物之间的联系、事件发生的逻辑和背后的常识,并且能基于这些人类社会的经验来做出更好的驾驶策略。

在开放合作上,DriveGPT致力于打造一个开放的大模型生态,毫末DriveGPT也取得了政府和行业的权威认可,并在今年5月成功入选“北京市通用人工智能产业创新伙伴计划”,成为首批模型伙伴观察员。

而在6月,DriveGPT入选北京市首批人工智能10个行业大模型应用案,同时毫末也荣获行业媒体颁发的2023中国AI基础大模型创新企业称号。这里我也再次欢迎更多伙伴加入DriveGPT生态,一同探索自动驾驶技术的新范式,抓住AI大模型技术的新机遇。

接下来,我将分享下DriveGPT的能力进化部分。

P9

DriveGPT包括感知大模型和认知大模型。

在感知大模型方向。我们通过对实现真实物理世界的学习,将真实世界建模到三维空间再加上时序的4D向量空间中。在构建对真实物理世界的4D感知基础上,我们也进一步引入图文多模态大模型,来完成4D向量空间到语义空间的对齐,实现跟人类一样的万物识别能力,我们称之为自动驾驶语义感知大模型。

而在认知阶段,基于语义感知大模型的万物识别能力,通过构建驾驶语言来描述驾驶环境和驾驶意图,再结合导航引导信息、以及自车历史动作,借助大语言模型的海量知识来辅助给出驾驶决策。大家都知道,大语言模型包含了人类世界所有知识的压缩,我们通过与大语言模型结合,使得自动驾驶认知决策获得了人类社会的常识和推理能力。这将大幅度提升我们自动驾驶策略的可解释性和泛化性,更快的实现万物移动的目标。

接下来,我也将逐步介绍下,这个架构中重要的三个部分:视觉大模型、感知大模型、认知大模型。

P10

首先是视觉大模型的进化,我们详细阐述一下在最核心的CV Backbone上,我们过去几年的探索和积累。

从模型架构上讲,大家都知道,早期的cv技术基本上都是以CNN类方法为主,但是最近几年,Transformer大模型在NLP领域取得巨大的成功,CV领域也大规模引入Transformer方法,以ViT为代表的视觉Transformer逐渐取代了各类CV模型。我们最早的将Tansformer引入到了自动驾驶领域,在过去的两年里,我们的CV Backbone也从CNN模型全面切换到ViT,并在今年全面升级到性能更强大的Swin Transformer。

而在训练范式上,过去几年我们也走过了一段飞跃式的发展。早期,我们是基于人工标注的单帧图片用有监督的方式来训练CNN类模型,后来结合4D自动标注技术,我们可以大规模、自动化地标注4D clips,于是我们的的训练方式也升级到基于自动标注的4D clips的有监督训练。但是这种有监督的训练方式,不管数据规模多大,模型的天花板始终受限于标注的效果和品类,无法做到万物识别。于是我们在业界率先升级到了基于大规模数据的自监督学习训练范式,通过这种方式,我们的Transformer大模型能轻松吃下上百亿的图片,模型见多识广,泛化能力自然就强了。

而我们最新的模型,则是采用视频生成的方式来训练的,通过预测生成视频下一帧的方式,来构建4D表征空间,使得CV Backbone能够学到三维的几何结构、图片纹理、时序信息等全面的物理世界信息,相当于把整个世界装到神经网络里了。

P11

在之前的AI Day上,我们公布了毫末视觉大模型的技术路线,视觉感知任务的核心目的都是恢复真实世界的动静态信息和纹理分布。我们最早采用的是基于ViT架构的方式来训练视觉backbone,在此的基础上我们又对视觉大模型做了一次架构升级,将预测空间三维结构、图片纹理分布融合到一个训练目标里面,强迫模型练好内功,来适配各种下游检测、分割等CV任务。

在这个视觉大模型中,图像编码器非常重要。它的训练采用的是自监督预训练学习的方式,因为只有这种方式才有能力处理高达百亿的图片。这种自监督方式是通过图像掩码恢复建模来提高预训练模型的图像表征能力,在去年的实践中,我们发现了一个非常重要的问题,即如何对图片做掩码,对下游的任务效果非常关键。我们基于自动驾驶任务的特殊性,对整个训练流程做了升级,具体的做法是:

首先对自动驾驶场景数据分割成多个patch, 然后基于自动驾驶对图片表征的特殊要求,对这些patch进行过滤,筛选出对自动驾驶最关键、信息含量最大的patch,再随机mask掉其中部分patch,让模型根据可见patch表征预测masked patch的表征来重建这些丢失的区域。

经过实验,在海量无标注的自动驾驶数据集上,通过自监督预训练的方式构建图片表征能大幅提升视觉表征学习能力,我们用这种方式进一步优化了毫末的CV backbone。

P12

在视觉大模型的基础上,我们又构建了多模态大模型来实现感知万物识别的能力。

在上次AI DAY上,我们已经公布了感知大模型的具体做法:将一个clips序列的前K帧的部分输入模型,要求模型的4D编码器提取出相关的动静态障碍物,路面、天气、光照等局部和全局的语义信息,形成4D特征空间。有了这个由前面K个时刻融合的4D特征,再输入解码器 3D空间的位置编码,经过神经辐射场就可以渲染出后续h帧的图片和深度。模型要想渲染得和真实后继视频一致,就得理解场景里面我们所关心的这些结构速度和纹理的核心信息。

在此基础上,我们今年又引入了多模态教师来提升模型的效果。这样,整个多模态感知大模型就可以分为3个关键的模块:4D编码器,多模态教师,Nerf渲染器。

我们通过这种方式,来构建了通用的自动驾驶感知大模型,实现在一个模型中同时学习到空间的三维几何结构、语义分割和纹理信息,具备识别万物的能力。也由此可以完成目标检测、目标跟踪、深度预测等各类任务。

P13

有了通用感知大模型之后,下一个核心的问题是如何构建认知大模型,我们要首先解决2个问题:

第一个问题是如何将感知大模型与认知大模型进行连接,实现端到端训练;第二个问题是除了感知模型看到的物理世界之外,自动驾驶认知决策阶段还需要引入什么信息?

对于第一个问题,我们还以沿用了毫末上次AI DAY的思路,将驾驶环境解码为BEV图来对接认知决策。

对于第二个问题,我们认为一个好的自动驾驶系统必须跟老司机一样懂得社会常识、知道这个世界各种现象背后的物理知识,我们认为只通过自动驾驶数据是无法训练出这个结果的,所以我们引入了外部的大语言模型。

大语言模型相当于学习并压缩了人类社会的全部知识,自然也包含了跟驾驶相关的知识。为了让LLM更好地适配自动驾驶任务,我们采用自动驾驶行业的数据通过LoRA的方式对LLM进行了微调,使得LLM能看懂驾驶环境,能解释驾驶行为,能做出驾驶决策。

自动驾驶为什么需要世界知识?我举个例子吧。大家知道,前不久,Cruise的Robotaxi已经可以在旧金山的开放道路上商业运营了。结果没几天,就有一台车陷到了一段没有干透的水泥路里。为啥这台Robotaxi会冲进去,就是因为它的感知里识别到那是一段平坦的路面,但是不知道车在这种没干透的水泥路会陷进去,这就是物理知识,也是一般人都知道的常识。而城市场景里有着类似这样无穷无尽的极端场景。所以自动驾驶想要开得好、变得真正像人一样聪明地驾驶,就必须掌握大量的世界知识。在我们看来,大语言模型就已经存储了这些世界知识,自动驾驶从大语言模型中能够学习到这些常识,以后就可以知道没有干透的马路不能开上去,遇到马路边的小孩子要比成年人更需要注意减速避让,遇到戴头盔的电动车的骑行者也需要提高警惕。

P14

最终我们把感知大模型、认知大模型对接,进行端到端训练,构建了毫末自动驾驶大模型DriveGPT。目前DriveGPT已经在自动驾驶系统开发的很多阶段给我们带来了巨大的提升。

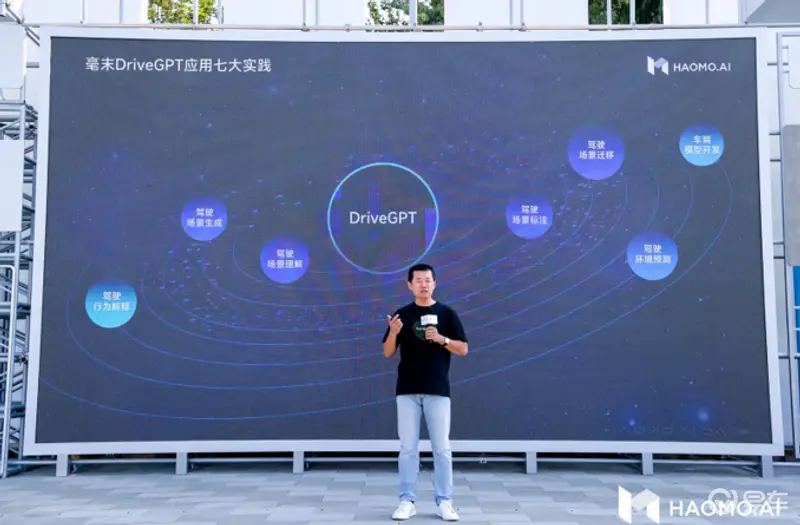

这次,我主要介绍在DriveGPT下的七大实践:

驾驶场景理解、驾驶场景标注、驾驶场景生成、驾驶场景迁移、驾驶行为解释、驾驶环境预测、车端模型开发。

这些实践让我们对自动驾驶的开发,彻底进入了一个和之前完全不同的模式中,我相信这种新的开发模式,将大大加速汽车智能化的进化进程。

P15

第一个实践,是如何更高效的筛选数据。

大家都知道,我们想去解决一个自动驾驶的Corner Case,必须准备一批跟这个Corner Case相关数据,传统的方式是采用标签加人工的方式,从高达百亿的数据中筛选出几万个有效数据,成本非常高、效率非常低。

在毫末通用感知大模型的加持下,我们利用图文多模态模型的视觉编码器,对毫末收集到的海量驾驶数据进行目标级别和全图级别的特征提取,变成图片表征向量,并对这些海量的向量数据建立向量数据库,实现秒级搜索。

开发工程师只需要用自然语言的方式,表达自己对场景图片的需求,例如隧道里的连续锥桶、遛狗的人等等,我们利用图文多模态模型的文本编码器,对于输入的任意搜索文本提取特征变成文本向量,再通过向量搜索去搜索刚才建立的向量数据库,就可以从这个百亿级别的向量数据库中找到该文本对应的驾驶场景数据。

对于驾驶环境特有场景,比如鱼骨线、双黄实线车道线,这些模型理解的并不好。为此,我们构建了毫末特有的自动驾驶场景多模态数据集,训练了毫末的图文多模态模型,来实现上述功能。

P16

第二个实践,是如何更高效的标注数据。

当我们筛选出一批数据之后,传统的开发模式是将这批数据送给标注公司,进行人工标注,效率低、成本高、周期长。

在之前的AI Day中,我们展示了跟自动驾驶密切相关的交通要素的自动标注能力,在业界引起了广泛的关注。但是,我们发现仅仅识别少数交通元素,称为闭集(Closed-set)场景标注,对自动驾驶来说还是不够,面对千变万化的真实世界的各类驾驶场景,我们很难用闭集的方式来穷尽各种目标的即快速又精准的标注。为此,毫末将闭集自动标注升级为开集(Open-set)场景中进行Zero-Shot的自动标注,这是一个标注能力上的飞跃,从此我们可以标注任意物体了。

我们借助大语言模型的能力来实现在开集场景中Zero-Shot的快速精准的自动标注。整体分为多模态模型蒸馏、大语言模型辅助、视觉语言特征交互三个部分。多模态模型蒸馏用于增强自动标注模型对语义、时空、颜色等的基础感知能力,大语言模型辅助用于提供开放词句的表征能力,视觉语言特征交互进行跨模态特征增强和感知,最终完成Zero-Shot的自动标注。

具体的实现方式是这样的:输入待标注的图片和文本,先分别用视觉Backbone提取视觉表征、用大语言模型提取文本表征,然后进行图文、文图的交叉注意力融合从而获得融合后的加强图文表征,然后在大语言模型的指导下选择合适的query、并通过一个跨模态解码器得到输出结果。

通过该方案,我们不仅实现了针对新品类的Zero-Shot快速标注,而且精度还非常高,预标注准召达到80%以上。

P17

第三个实践,是如何无中生有的可控生成技术。

我们发现,即使手里的数据再多,也会遇到大量hardcase数据不足的情况,为此我们基于大模型构建了毫末AIGC能力,来生成难以获取的数据。

我们首先基于毫末丰富的驾驶数据,训练了驾驶场景的文生图模型,可通过文字描述批量生成所需场景的图像数据。

但是,我们发现这样生成的图像有几个问题,一是没有标注,很难直接用于下游监督训练;二是驾驶数据场景复杂,很难用文字进行细节描述,针对感知模型关注的障碍物、车道线、红绿灯等,更是难以用文字去进行详细的定位。

为此我们在文本描述之上,又引入了适用于驾驶场景的额外引导,基于基础文生图模型,我们在扩散模型的Encoder和Decoder部分都通过类似于hypernetwork的结构加入了额外引导的信息。

以车道线引导为例,我们可以基于车道线的标注结果,甚至手绘的车道线示意图,比如路口、大区率弯道等车道线,再以这个标注结果或者手绘图作为引导,来生成对应的图像。基于这样的技术生成的图像,一方面可以通过标注进行更加精细的位置控制,另一方面新生成的数据相当于自带了标注信息,就可以直接用于训练了。

这种生成技术,我们称之为无中生有的可控生成技术。

P18

第四个实践,是如何高效的进行场景迁移。

除了基于标注结果的数据生成之外,之前的AI Day上,我们也展示了白天转夜晚、白天转雪天等场景迁移的效果,我们当前AIGC的生成效果又有了明显的提升。通过引入文字引导,用单个模型实现了多目标场景生成。

技术方案与上一页的可控数据生成一样,基于毫末的感知大模型,以真实的采集图像作为引导,通过文本语言来描述希望生成的目标场景,可实现清晨、正午、黄昏、夜晚等多时间段光照变换,同时也可把晴天转换为雨天、雪天、雾天等各种极端天气。通过这种方式,能将采集到的一个场景,迁移到该场景的不同时间、不同天气、不同光照等各类新场景了,极大地丰富了训练数据,提高了模型在极端场景下的泛化性。

这种生成技术,我们称之为瞬息万变的场景迁移技术。

P19

第五个实践,是让AI解释自己的行为。上次AI Day,我们也做过类似的尝试,即通过毫末场景库、结合人工标注的方式来对驾驶行为做出解释,不同的场景可以给出不同的驾驶解释。但是我们发现这种解释方式仅能处理少量典型的场景,面对开放的世界是远远不够的,于是我们尝试引入外部的大语言模型来解释驾驶环境。

我们首先将感知大模型的结果解码,输出当前的感知结果,然后综合感知到的外部环境信息、自车信息和驾驶意图,我们构造了典型的Drive Prompt,将这些Prompt输入大语言模型,让大语言模型对当前的自动驾驶行为做出解释,这样的解释输出一方面能解决大模型不可解释的问题,另一方面也能基于这些驾驶解释来进行驾驶决策的优化。

通过这种方式,我们能对复杂的驾驶行为给出合理的解释,例如为什么要加速、为什么要减速、为什么要变道等。但是当前的解释还比较宽泛,不够详细不够具体,更像是看图说话写作文,我们未来打算构建自动驾驶描述数据,来对大语言模型进行微调,让大语言模型能够像驾校教练或者陪练一样,对驾驶行为做出详细的解释。

P20

第六个实践,是如何准确的预测未来。

上次AI Day,毫末在业界第一次提出了基于已有BEV来生成未来BEV的生成式自动驾驶大模型DriveGPT,对DriveGPT的训练方法进行了详细的阐述,我们借此机会来回顾一下:

我们通过对BEV图进行栅格化,构建自动驾驶语言Drive language,再使用GPT的方式对Drive language进行建模,生成未来的BEV视图。

我们采用了海量司机的驾驶行为来进行预训练,再引入司机接管数据作为人类反馈数据,来进行强化学习,希望能对未来的世界做出非常好的预测。

但是,在实践过程中,我们也遇到了很多的难题,例如如何让自动驾驶像人类一样具备社会常识、懂得人类社会的潜规则,并且基于这种潜规则做出更好的预测,我们发现光靠驾驶行为数据很难学习到这种复杂的人类社会常识,于是我们引入了大语言模型,我们认为只有通过大语言模型,才能获取这种人类社会的知识或者常识并给出合理的建议。

在具体实现上,我们是这么做的:首先通过感知大模型,来对周围的物理空间进行编码,然后解码输出BEV视角的感知结果,token化之后输入生成式大模型,让模型预测未来的BEV视图。相对于上次的模型,我们这次引入了大语言模型,将感知结果输入大语言模型后,让大语言模型对当前的驾驶环境给出解释和驾驶建议,再将驾驶解释和驾驶建议作为prompt输入到生成式大模型,来让自动驾驶大模型获得外部大语言模型内的人类知识。

我们相信,必须要引入大语言模型,才能让自动驾驶具备常识,而自动驾驶必须具备常识,才能理解人类社会的各种明规则、潜规则,才能跟老司机一样,与各类障碍物进行更好地交互。

P21

第七个实践,是大模型如何在有限的车端算力上运行起来。

众所周知,大模型是基于云端海量的数据、数千块GPU卡训练出来的,这么大的模型,是如何上车的呢?显然,短期内直接把大模型部署到车端芯片还是比较困难。我们探索的是蒸馏的方式。

一方面我们可以使用大模型来输出各类伪标签,然后这些伪标签既可以作为训练语料,来丰富车端小模型的训练数据,也可以作为监督信号,让车端小模型来学习云端大模型的预测结果。

另一方面,我们可以可以通过对齐Feature Map的方式,让车端小模型直接学习并对齐云端的Feature Map,从而提升车端小模型的能力。

基于这种蒸馏的方式,我们可以让车端的感知效果提升5个百分点。

P22

这7个实践会陆续落实到我们的产品上,比如纯视觉泊车。

随着毫末视觉感知技术的逐步升级,我们的视觉感知能力显著提升。泊车场景下,尤其是泊入阶段,通常都是依赖USS进行距离感知,但USS感知范围有限,且无法输出精确的物体轮廓,对于车体两侧存在盲区。为了充分利用鱼眼相机的环视感知能力,我们将鱼眼相机也引入到视觉BEV的感知框架当中,鱼眼图像先进行虚拟相机转换,并通过视觉Backbone提取出视觉特征,经过空间转换映射至BEV空间,并在该空间下对于障碍物的轮廓边界进行识别和测量。如这个视频所示,目前我们使用鱼眼可以识别墙、柱子、车辆等各类型的边界轮廓,形成360度的全视野动态感知,目前可以做到在15米范围内达到30cm的测量精度,2米内精度可以高于10cm。这样的精度可以让我们用视觉取代USS,进一步降低整体方案的成本。

P23

毫末车端感知,通过引入云端开集语义图像检索,实现对多种多样的通用障碍物的高效挖掘和学习,并通过蒸馏方式让车端模型与云端的训练结果进行特征对齐,从而提升了对道路上小目标障碍物的检测和识别。经过测试,毫末城市NOH可以在城市道路场景中,在时速70公里的50米距离外,就能检测到大概高度为35cm的小目标障碍物,并做到完全自主的绕障或刹停,在80、90公里时速上也能有比较好的绕行表现。

P24

毫末率先走了一条重感知轻地图的技术路线,这条路本身要比直接走高精地图的技术路线实现起来会遇到更多难题,但是重感知路线真正实现之后又将比重地图路线有着更好的泛化优势和更快的开城能力。

根据毫末和长城在城市NOH车型上的规划,我们将在2024年的Q1正式上市搭载毫末HP550产品也就是具有城市NOH功能的魏牌蓝山。

在这段“间隔”期,毫末的城市NOH也并不是交付之后就止步不前了。我们现在正在感知模块上面进行不断的优化,特别是针对城市场景,比如不断提高感知算法在识别各类交通场景中的障碍物的数量和范围,并且不断挑战平时少见的极端场景。

这是我们邀请媒体AutoLab测试的一段视频,就是针对道路上出现的小目标障碍物的检测和避让,在实际场景上通常就是路上突然串出的小猫小狗。目前我们可以做到在城市道路中时速最高70公里在50米的距离下就能检测到大概35cm高的小目标障碍物,可以做到100%的成功绕障或刹停。我们也在继续测试更多的极端场景,尽可能还原更真实的效果。我们希望在接下来的三个月时间里,可以让城市NOH拥有更强大的“见多识广”的能力。

P25

我们的小魔驼近期也进展迅速,在城市开放道路的无人驾驶状态下,我们普通人骑自行车已经追不上了。不管是在行驶安全上,还是通行效率上,都已经达到了商用的状态。在这个实践过程中,非常感谢物美、达达对我们的支持。

从产品场景上,毫末小魔驼做商超配送场景,实现人机优势互补,在机器人擅长的地方替代人力,在人力擅长的地方人机交互,从而实现全局效率更高,成本更低。

从商业意义上,毫末具备了成为全球范围内首家拥有规模化盈利 L4业务公司的能力。如刚才我们也介绍了89999的小魔驼3.0,如果是这样的成本、这样的无人驾驶能力,小魔驼即将在2023年第四季度在商超场景实现了场景盈利。

我们也期待有更多的客户可以在更多的场景中,使用L4级的自动物流车小魔驼。

P26

当然我们DriveGPT的云端能力也对外开放,合作伙伴可以通过使用API、模型的专项优化、服务的私有化部署,与我们合作。

到目前为止,我们已经服务包括上次8家在内的17家生态伙伴,并且开始了模型服务商业化的新阶段。

P27

像毫末这样的创业型企业,唯有不断的技术创新,才能存活下来,持续发展。

到目前为止,我们已经获得专利证书206件

在上次AI DAY后,又有两篇论文在技术顶刊中发表,这些论文,也是对我们工作实践的总结,是我们毫末发展中的知行合一。

这次我也简单介绍下这两篇新论文。

P28

第一篇BEVPlace是发表在ICCV2023的论文,ICCV是计算机视觉和模式识别的全球顶级学术会议。BEVPlace主要解决地点识别的问题,它通过匹配地图和传感器的观测,在GNSS 信号未覆盖或被遮挡(高楼、隧道等)的场景,也能实现精确的全局定位(处于地图的哪一个位置)。

BEVPlace首先通过实验验证了基于BEV表征的卷积网络能够在弱视角变换的场景超过业内其他方案,同时具有强大的泛化能力。然后基于等变结构提取等变特征,构建了一个旋转不变的全局特征提取器。该网络对无人车视角变化鲁棒,同时具有更高的定位性能。另外,BEVPLace还探索了特征空间和几何空间的统计相关性,基于统计分析,提出使用特征距离来进行快速定位的方法,为端到端定位提供了一个新的视角。

BEVPlace在各个公开数据集上实现了SOTA性能,能够在少量训练数据上泛化到大场景中去。我们也正在基于BEVPlace作进一步的改进,到年底会完成一个实时、轻量、高精度的全局定位模块,用于我们的产品中。

P29

第二篇论文I2P-Rec发表在IROS2023,这篇文章使用相机在点云地图中实现全局无人车定位,探索低成本高精度定位的可能性。

图像和点云是两种在成像内容和格式上都大不相同的数据,为了统一两者的模态信息,I2P-Rec使用深度估计网络模型,对输入的图像数据估计深度并反投影成点云,统一在BEV空间中提取图像和点云的全局特征,实现全局定位。运用我们的方法,在KITTI数据集上使用少量的训练数据就可以达到90%以上的Top-1%(Top百分之一)召回率。

这两篇论文是近期毫末同学的学术输出,感兴趣的同学可以找到原文和GitHub与我们一起切磋。

P30

这里再简单回顾下毫末过去历次AI DAY上的技术观点和重大发布。

这代表了毫末一以贯之的技术思考。

我们在2021年3月的第一届AI DAY上提出了自动驾驶发展三定律,明确了毫末渐进式发展的技术产品路线,6月第二届AI DAY上,首次对外公布了毫末在视觉Transformer技术落地自动驾驶的进展,12月第四届AI DAY上,率先发布行业首个自动驾驶数据智能体系MANA雪湖。

2022年4月,第五届AI DAY上,我们发布了自主研发的基于Transformer架构的BEV感知技术思路,也是国内第一家提出以不依赖高精地图的“重感知”方式实现城市NOH的自动驾驶AI公司;9月,第六届AI DAY上,我们提出自动驾驶3.0时代,提出大模型、大数据、大算力将成为自动驾驶技术发展的核心特征。

2023年1月,第七届AI DAY上,毫末建成了行业算力最大的自动驾驶智算中心MANA OASIS雪湖·绿洲,并同时发布了五大自动驾驶感知和认知领域的大模型,首次将GPT技术思路引入到自动驾驶认知决策领域。

而在今年4月,第八届AI DAY上,毫末正式推出行业首个自动驾驶生成式大模型DriveGPT雪湖·海若,首先实现对自动驾驶认知决策模型的持续优化,同时也在将多个感知大模型的训练纳入到DriveGPT统一的架构中,目标是实现端到端自动驾驶。

现在,第九届AI DAY,DriveGPT发布的200天,我们更加坚定这一技术路线,我们将通过统一的DriveGPT大模型架构来整合通用感知和通用认知能力,让通用感知实现万物识别、让通用认知具备世界知识,让自动驾驶实现一次技术范式的跃迁。

P31

以上是我今天关于AI DAY技术部分的分享。

让我们把时间拨回2019年11月29日,那一刻,用现在的一个流行说法:命运的齿轮开始转动,毫末人的命运由此聚在一起。

这群固执地相信技术,想要亲手创造自动驾驶未来的人,一步一个脚印,合抱前行。近四年时间,我们日夜兼程,一分钟一秒钟都不敢懈怠。遇到困难,永远永远不放弃,打下一场又一场的技术、产品、生态战役……冲刺决胜自动驾驶3.0时代。

四年后,就在今年的11月29号,毫末将迎来4岁生日。四年前,我们从北京、保定出发,到上海、深圳、乃至德国都种下了自动驾驶的种子,用AI连接更广阔的世界,用技术叩问更浩远的未来。

现在,毫末的同学们,一约既定,万山无阻。走过黑夜,就见乾坤。

P32

每次AI DAY,除了技术分享,我们还有一个非常重要的任务,就是招人。

现在毫末的北京、保定、上海、深圳、德国慕尼黑五大研发中心都在持续招聘中,面向全球招聘顶尖自动驾驶人才。

毫末的愿景是:让机器智能移动,给生活更多美好。

我们诚挚邀请那些心中有梦、眼中有光、手中有剑,胸怀技术梦想,相信技术必将改变世界的同学们加入毫末,加入一起携手实现自动驾驶梦想。

谢谢大家。

内容由作者提供,不代表易车立场